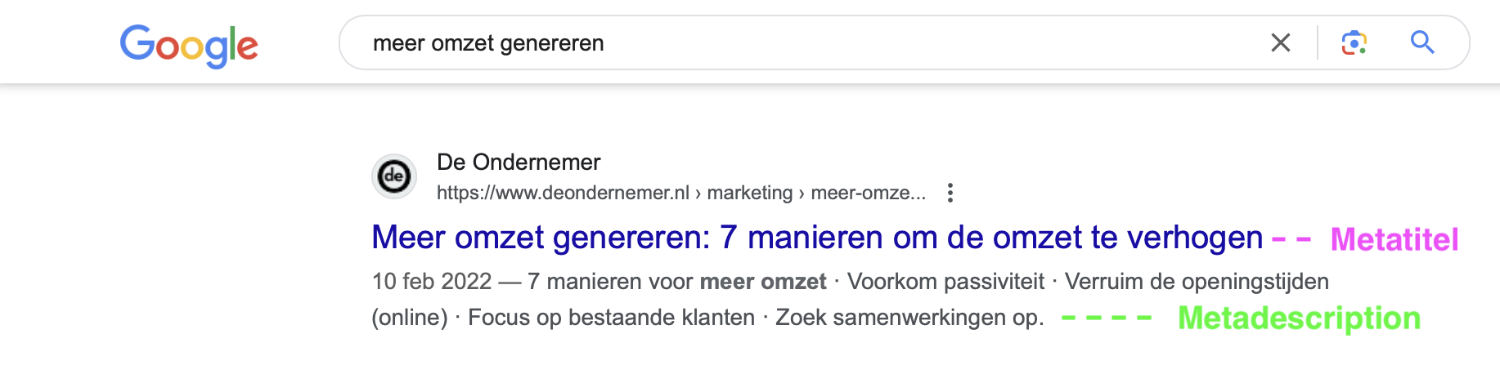

Wat is een robots.txt bestand?

Een robots.txt bestand is een simpel tekstbestand dat websitebouwers gebruiken om zoekmachines te vertellen welke delen van hun website wel of niet bezocht mogen worden. Dit bestand kan ervoor zorgen dat bepaalde pagina’s of mappen op een website niet worden bekeken door zoekmachines zoals Google. Daardoor komen deze pagina’s niet in de zoekresultaten terecht en zal je ze dus ook niet via Google kunnen terugvinden. Dit helpt om de prestaties van de website te verbeteren en te zorgen dat ongewenste inhoud (denk bijvoorbeeld aan persoonsgegevens) niet zichtbaar wordt in zoekmachines.

Dus:

Het robots.txt bestand is heel belangrijk voor hoe goed je website gevonden wordt op zoekmachines, wat we SEO noemen. Soms kunnen websites problemen hebben met gevonden worden omdat er fouten staan in dit kleine bestandje.

In dit artikel

Waar vind ik het robots.txt bestand?

Het robots.txt bestand moet in de hoofdmap (de root) van je website staan. Dit betekent dat je het moet kunnen vinden door naar www.jouwwebsite.com/robots.txt te gaan.

Een voorbeeld van onze sitemap kun je gemakkelijk bekijken op:

Onderdelen van een robots.txt bestand

3.1 User-agent

Een User-agent is een stukje software dat namens een gebruiker het internet doorzoekt. Dit kan bijvoorbeeld een zoekmachine zoals Google zijn. Google, Baidu en Bing hebben zelf speciale User-agents, die we ook wel bots of crawlers noemen. Die crawlers bezoeken je website om de inhoud te indexeren. Het robots.txt bestand gebruikt de term “User-agent” om aan te geven welke zoekmachines bepaalde regels moeten volgen.

Algemene User-agent

Bij een algemene user-agent in je robots.txt bestand bepaal je welke regels er voor alle zoekmachines gelden.

Bijvoorbeeld:

Hiermee zeg je het robots.txt bestand dat geen enkele zoekmachine de map “privé” mag bekijken.

Specifieke User-agent

Een specifieke user agent bepaalt de regels alleen voor een bepaalde zoekmachine.

Bijvoorbeeld:

Hier zegt het robots.txt bestand dat alleen Googlebot de map “geheim” niet mag bekijken. Andere zoekmachines mogen dit wel.

3.2 Dissallow

Volledige website toestaan

Dit voorbeeld laat alle zoekmachines toe om de hele website te indexeren. Het zegt eigenlijk “alles is toegestaan”.

Volledige website uitsluiten

In dit geval wordt alle zoekmachines verteld om de gehele website niet te indexeren. Het betekent dat geen enkel deel van de website zichtbaar zal zijn in zoekresultaten.

Specifieke directories uitsluiten

Stel je hebt een map op je website genaamd “/geheim/” en je wilt niet dat zoekmachines daar in kijken:

Met deze regel wordt alle zoekmachines verteld om de map “/geheim/” en alle bestanden binnen die map niet te indexeren. Dit zorgt ervoor dat de inhoud van die specifieke map niet in zoekresultaten zal verschijnen.

3.3 Allow

Stel dat je omwille van bepaalde redenen een gehieme map hebt uitgesloten van de zoekmachines, maar je wil wel dat er één bepaald bestandje wél gevonden kan worden, dan kun je gebruikmaken van de allow-richtlijn. Daarmee vertel je zoekmachines welke specifieke pagina’s of mappen ze mogen bekijken, zelfs als andere delen van de website zijn uitgesloten van indexering.

Voorbeeld van specifieke pagina’s toestaan binnen uitgesloten directories

Stel je hebt een website met een map genaamd “geheim” waar je normaal gesproken niet wilt dat zoekmachines in kijken. Hier is hoe je een specifiek bestand in die map kunt toestaan:

In het voorbeeld zegt de robots.txt file dus dat alle zoekmachines niet de map “/geheim/” mogen bekijken, behalve het bestand “/geheim/toegestaan-bestand.html”. Dat specifieke bestand mag dus wel worden geïndexeerd, zelfs wanneer de rest van de map geheim moet blijven.

3.4 Crawl-delay

De Crawl-delay richtlijn in het robots.txt bestand geeft aan hoe lang zoekmachines moeten wachten tussen elke keer dat ze pagina’s van je website crawlen. Het is als het instellen van een snelheidslimiet voor zoekmachines, zodat je server niet overbelast raakt.

Ondersteuning door verschillende zoekmachines

De Crawl-delay richtlijn wordt niet door alle zoekmachines ondersteund. Hier is hoe het zit:

Google: Google ondersteunt de Crawl-delay richtlijn niet. In plaats daarvan kun je de crawlsnelheid instellen in Google Search Console.

Bing: Bing ondersteunt de Crawl-delay richtlijn. Je kunt een waarde instellen in seconden.

Yahoo: Yahoo ondersteunt ook de Crawl-delay richtlijn, vergelijkbaar met Bing.

Yandex: Yandex, een zoekmachine die populair is in Rusland, ondersteunt ook de Crawl-delay richtlijn.

Voorbeeld van gebruik

Stel dat je wilt dat zoekmachines langzamer je website crawlen om je server te ontlasten, bijvoorbeeld met een delay van 10 seconden:

Met deze regel vertel je aan alle zoekmachines om na elke pagina die ze crawlen, 10 seconden te wachten voordat ze een volgende pagina van je website ophalen. Dat zogt ervoor dat je server niet te zwaar belast wordt door de crawlers van zoekmachines en je website niet teveel laadtijd verliest.

3.5 De sitemap

Een sitemap is een van de meest essentiële aspecten van iedere technische SEO. Het is een speciaal bestand op je website dat een lijst bevat van alle pagina’s waarvan je wil dat zoekmachines ze vinden en indexeren. Door de locatie van je sitemap op te nemen in het robots.txt bestand, navigeren zoekmachines efficiënter door je website en ben je er zeker van dat ze alle belangrijke pagina’s te ontdekken en indexeren.

Hier is hoe je de locatie van je sitemap toevoegt aan je robots.txt bestand:

In dit voorbeeld is https://www.studiocapiche.com/sitemap.xml de URL naar het sitemapbestand op onze website. Door deze regel toe te voegen, geef je zoekmachines aan waar ze je sitemap kunnen vinden, waardoor ze gemakkelijker alle belangrijke pagina’s kunnen indexeren.

3.6 No-Index

Misschien denk je nu dat het gemakkelijker is om je webpagina’s gewoon ene noindex tag mee te geven. Maar het is niet slim om Noindex in het robots.txt bestand te zetten, omdat het daar niet voor bedoeld is. Robots.txt vertelt zoekmachines alleen welke delen van een website ze mogen bekijken (crawlen), niet of ze een pagina mogen indexeren.

Betere manieren om te voorkomen dat bepaalde pagina’s geïndexeerd worden

Meta Robots-tag in HTML: Als je wil dat een pagina niet in de zoekresultaten verschijnt, kun je een stukje code in de HTML van de pagina zetten. Dit ziet er zo uit:

Deze code vertelt zoekmachines om de pagina niet te indexeren (noindex), maar wel om de links op de pagina te volgen(follow).

X-Robots-Tag HTTP-header: Voor bestanden zoals PDF’s of afbeeldingen die niet direct met HTML bewerkt kunnen worden, kun je de X-Robots-Tag HTTP-header gebruiken. Dat wordt door webontwikkelaars ingesteld op de server. Bijvoorbeeld:

Gebruik van robots meta-tags: Als je ingewikkelder regels wilt gebruiken om specifieke pagina’s of delen van je site uit te sluiten, kun je gedetailleerde robots meta-tags gebruiken in plaats van het robots.txt bestand.

Door deze methoden goed te gebruiken, zorg je ervoor dat zoekmachines weten welke pagina’s ze moeten indexeren en welke niet, zonder dat je de regels van het robots.txt bestand overtreedt.

Veelgemaakte fouten bij een robots.txt bestand

Ben je al wat thuis in de wereld van technische SEO, dan zul je merken dat er vaak wat fouten sluipen in de locatie of de inhoud van het robots.txt bestand. Hieronder som ik enkele veelvoorkomende fouten op bij het maken of gebruiken van een robots.txt bestand.

Verkeerd gebruik van Disallow

Mensen denken soms dat Disallow betekent dat zoekmachines een pagina niet kunnen vinden, maar het betekent eigenlijk dat ze de pagina niet zullen indexeren. Dit kan verwarrend zijn als je juist wilt dat een pagina niet gevonden wordt.

User-agent: * Disallow: /geheime-pagina/De code hierboven zorgt ervoor dat zoekmachines de pagina /geheime-pagina/ niet indexeren, maar als iemand een link deelt naar die pagina, kunnen mensen deze nog steeds vinden.

Absolute URLs in plaats van relatieve

Een robots.txt bestand is alleen geldig voor de website waar het zich bevindt. Absolute URLs naar andere websites werken niet in een robots.txt.

Disallow: https://anderwebsite.be/geheime-pagina/Dit zal niet werken zoals bedoeld, omdat robots.txt alleen werkt voor de huidige website.

Plaatsing in subfolders

Een robots.txt bestand moet altijd in de hoofdmap (root) van de website geplaatst worden. Als het in een submap staat, zal het niet correct werken.

https://mijnwebsite.be/mijn-website/robots.txtVerkeerde schrijfwijze van URLs

Het gebruik van onjuiste spelling of hoofdletters in URLs kan ervoor zorgen dat de robots.txt regels niet worden toegepast zoals bedoeld.

Disallow: /Geheime-pagina/Dit zal niet werken als de echte pagina /geheime-pagina/ met een kleine letter ‘g’ is.

Door deze fouten te vermijden en correct gebruik te maken van het robots.txt bestand, kun je ervoor zorgen dat zoekmachines je website correct indexeren zoals jij dat wil.

Conclusie

Samengevat is het robots.txt bestand dus eigenlijk een simpel tekstbestandje dat websitebouwers gebruiken om aan zoekmachines zoals Google te vertellen welke stukjes van hun website wel of niet gezien mogen worden. Dit is handig als je bijvoorbeeld privépagina’s hebt of bepaalde informatie liever niet in zoekresultaten terugziet. Het bestandje moet altijd in de hoofdmap (root) van je website staan, zodat zoekmachines het meteen kunnen vinden als ze je site bezoeken. Op die manier heb je zelf controle over wat er wel of niet opduikt als mensen via Google zoeken.

Zelf eens een technische SEO analyse laten uitvoeren?

Wil je de vindbaarheid van je website verbeteren op zoekmachines zoals Google? Dan kan het zinvol zijn om een technische SEO-analyse te laten uitvoeren. Hiermee ontdekken we hoe goed je website is geoptimaliseerd voor zoekmachines en welke aspecten mogelijk verbeterd kunnen worden. Een technische SEO-analyse richt zich op de technische aspecten van je website die invloed hebben op de indexering en ranking in zoekmachines. Interesse? You know the drill.